Arkadaşlar Merhabalar,

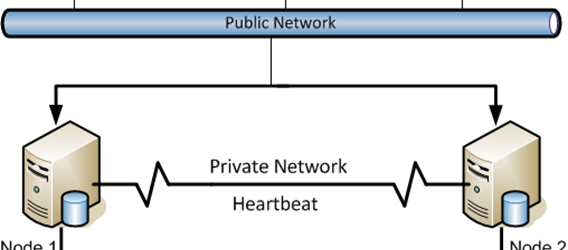

Failover cluster, sistemlerin erişim seviyesindeki başarısızlıklarına karşı alınan bir clustering teknolojisidir.

Cluster içindeki her bir sistem node olarak adlandırılır ve her an üzerine düşen işi yapabilecek durumda olmalıdır.Sistemlerdeki backup, kurulum, yapılandırma, altyapı faaliyetleri sırasında ortaya çıkan sorunların sistemi etkilememesi ve sistemin kaldığı yerden devam etmesi açısından failover cluster teknolojisi büyük önem kazanıyor.Dolayısı ile bu teknolojinin gelişmesindeki en önemli etken erişilebilirlik ihtiyaçlarının artmasıdır.

Bu topolojide Aktif/Aktif çalışan bir sistem olacaktır.Bu sayede Cluster Shared Volume’a değinilecektir. Server 2016 Release 5 te Hyper-V stabil çalışmadığı için yapıyı Server 2012R2 üzerinde kuruyorum.Tüm topoloji Vmware Workstation üzerinden çalışmaktadır.

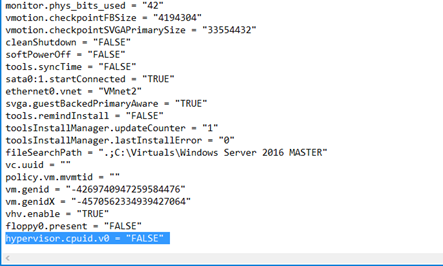

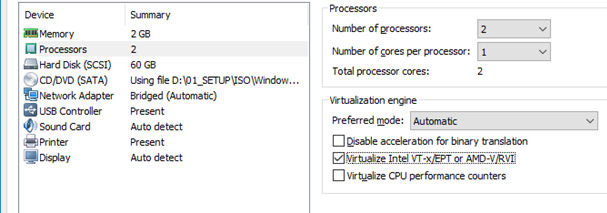

Öncelikle Failover cluster yapılacak makinalara hyper-v kurulur.Bunu Vmware Workstation da yapabilmek için önce “Virtualize VT-X/EPT or AMD –V/RVI” yi sanal makinanın processor özelliklerinden işaretledikten sonra, vmware in konfigürasyon dosyasının sonuna hypervisor.cpuid.v0 = “FALSE” parametresini girmek gerekiyor. Tabi işlemcininde virtualization destekli olması şart.

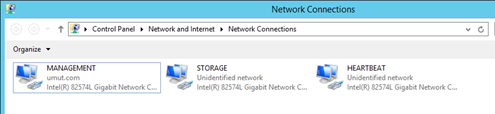

Bu ayarları yaptıktan sonra domaindeki sanal makinalarımızın NIC ayarlarını yapıyoruz.Ben kendi topolojimde 3 adet network kartı kullandım.Gerçek hayatta data kayıplarının en aza indirgenmesi için gigabitlik ethernetler kullanılır.

1.Kart = Management –Vmnet2 DC ile haberleşirken kullanılan kart

2.Kart = Storage – Bridge Cluster disklerine erişilirken kullanılan kart

3.Kart = Heartbeat – Vmnet3 Clusterların çalışıp çalışmadığını kontrol eden kart.

Nodelar arasında sıkıntı çıkmaması için işletim sistemi versiyonları, updateleri, ve konfigurasyonları benzer olmalıdır.Bir sıkıntı çıktığı takdirde cluster yaparken Validate Configuration dediğimizde sorunlar çıkacaktır.Storage ile DC yi aynı makina üzerinden yapılandırıldı.Network ayarları aşağıdaki gibi,

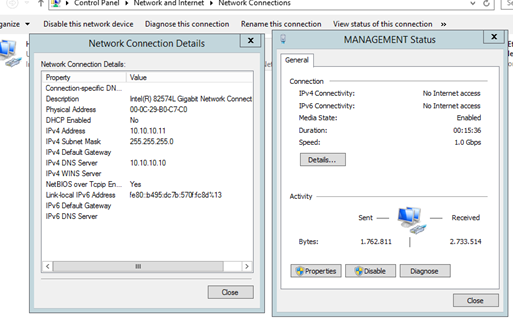

Management Network ID: 10.10.10.0/24

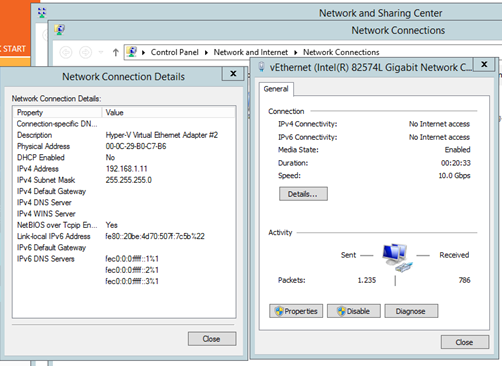

Storage Network ID: 192.168.1.0/24

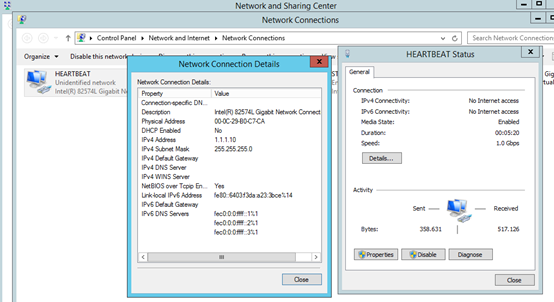

Heartbeat Network ID: 1.1.1.0/24

————————————————————

Node 1:

Management NIC IP: 10.10.10.11

Storage NIC IP: : 192.168.1.11

Heartbeat NIC IP: 1.1.1.1

Node2:

Management NIC IP: 10.10.10.12

Storage NIC IP: : 192.168.1.12

Heartbeat NIC IP: 1.1.1.2

Storage – DC:

DC (Management) IP: 10.10.10.10

Storage NIC IP: 192.168.1.10

—————————————————-

Node 1 in IP configurasyonu aşağıdaki resimlerde de verilmiştir

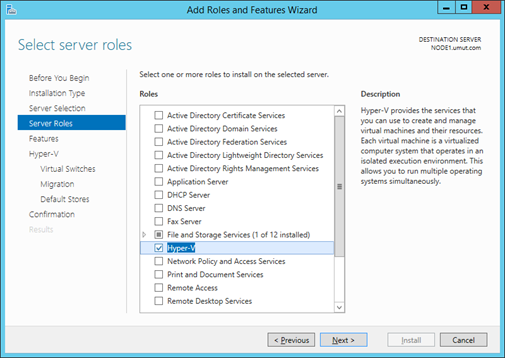

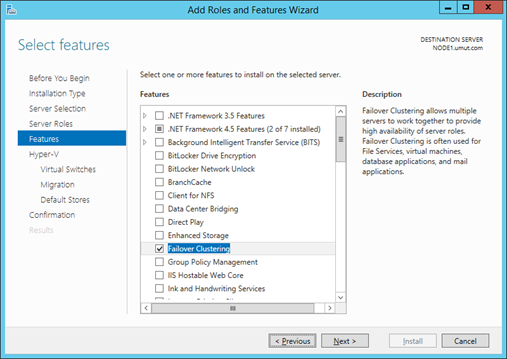

IP konfigürasyonu yapıldıktan sonra node’lara Hyper-V rolü ve Failover Clustering feature’ı yüklenir.

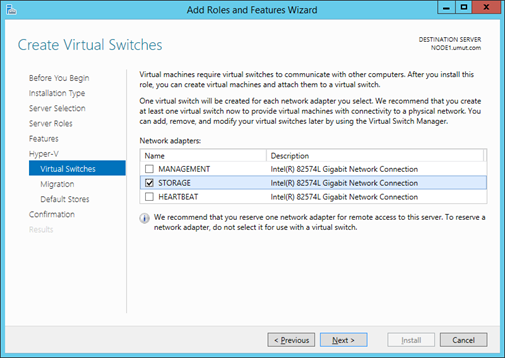

Aşağıdaki adımda Node ların bağlı olduğu diğer makinalarla konuşacağı fiziksel networkü seçiyoruz.

Benim fiziksek networküm Storage’ların bulunduğu network olduğu için STORAGE ı seçtim.

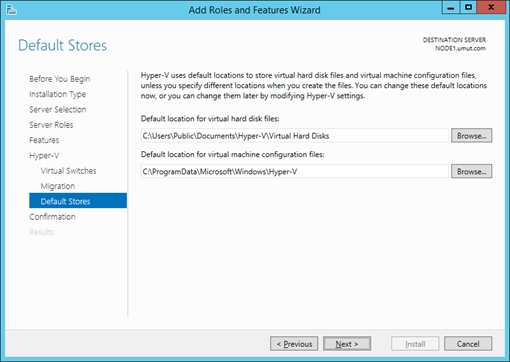

Aşağıdaki adımda Sanal makina disklerinin ve konfigurasyon dosyalarının bulunduğu dizini seçiyoruz.

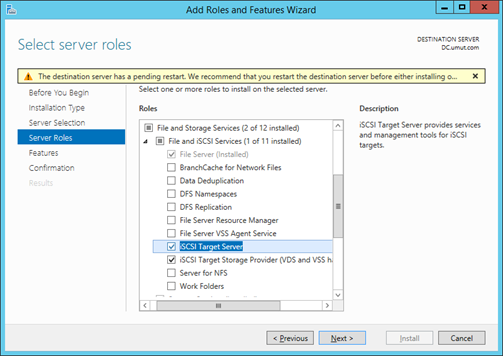

DC mi Storage olarak kullanacağım için DC ye ISCSI Target ve ISCSI Target Storage Provider (isteğe bağlı olarak) yüklenir.

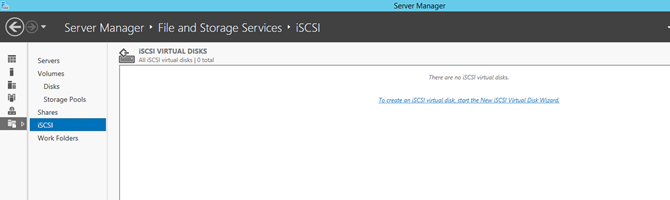

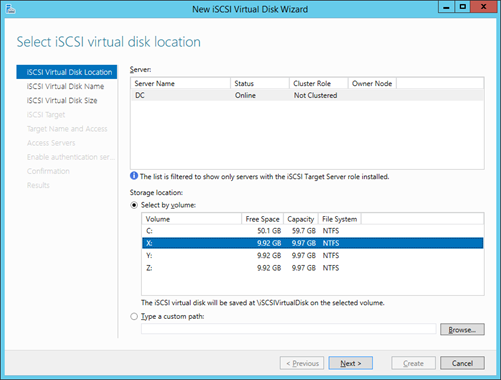

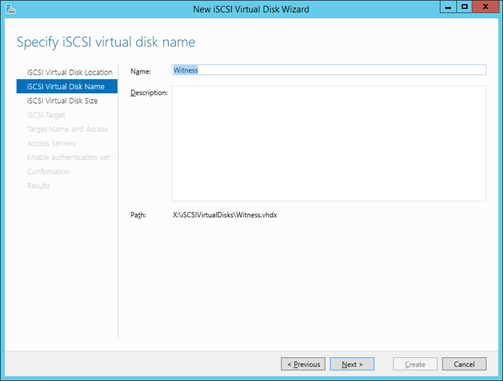

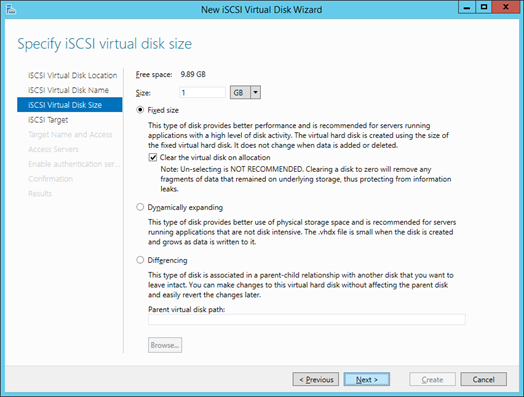

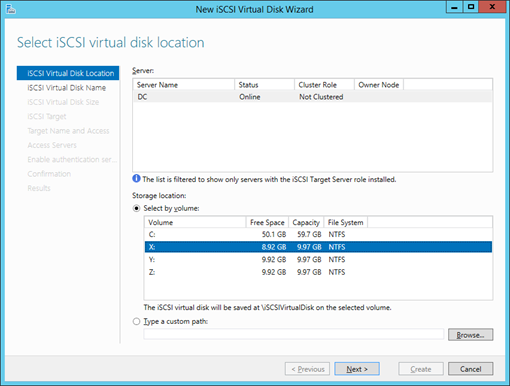

Şimdi Server Managerdan File and Storage Services ten ISCSI ye geldikten sonra sağ tarafta Sanal disklerimizi görürüz.Ben yeni bir diskler create edeceğim. Bir tanesi Witness(quorum) için diğeride Clusterların ortak göreceği diskler.Quorum diski için 1 gb ayıracağım.Diğer diskleri istediğimiz gibi seçebiliriz.Tabi içine sistem konulacağı için bunu göz önünde bulundurarak ayıracağız.

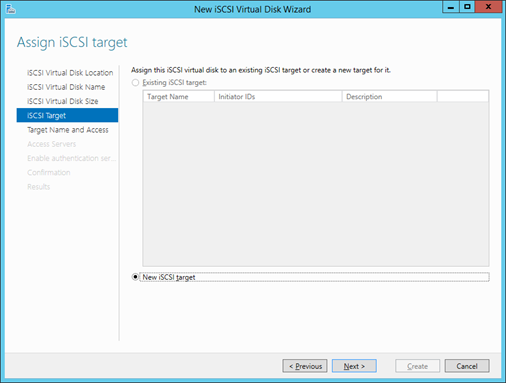

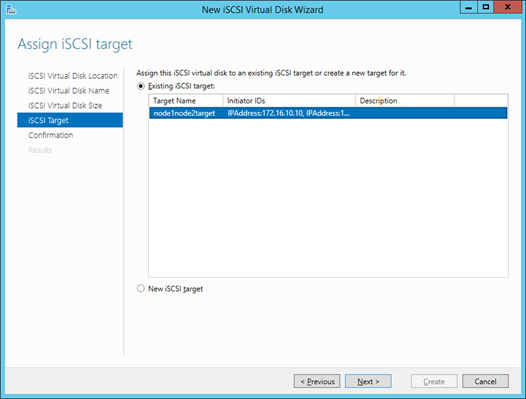

Bu diskleri kime Target edeceğimizi ayarlayacağız.New ISCSI target ile devam ediyoruz

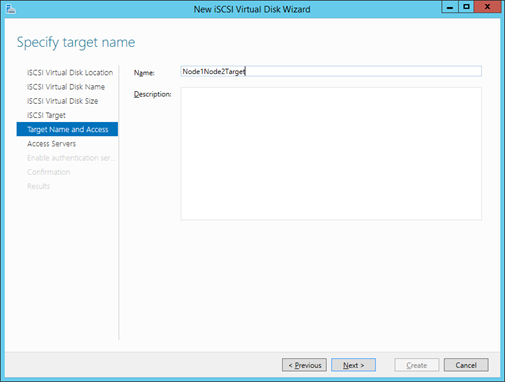

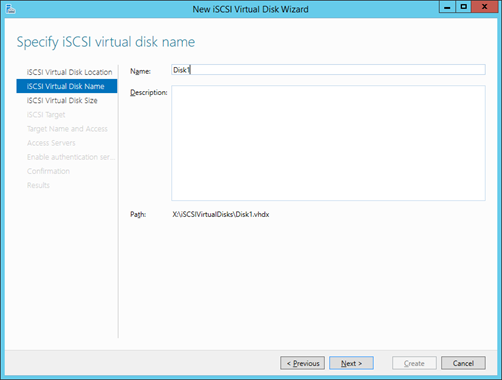

Bir isim vermemiz gerekiyor

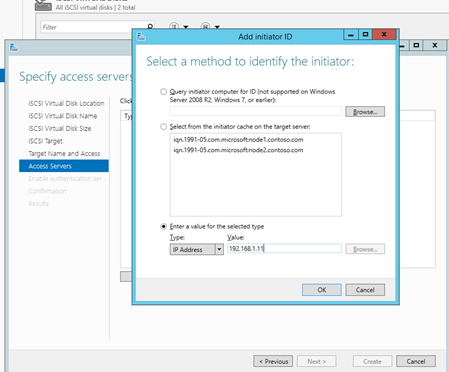

Bir sonraki aşamada Targetları ayarlayacağız.Bunun için add ve açılan yerde Enter a value for the selected type ifadesinin altından defaultta IQN yazan yeri IP Adress olarak değiştirip Node’ların IP adresini yazıyoruz.

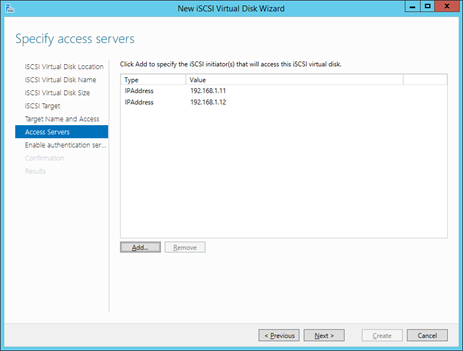

192.168.1.11 ve 192.168.1.12 yi ekliyoruz.Bu ipler bu diskleri kullanacak Node’ların Storage IP’si

İki IP leri ekledikten sonra create ediyoruz.Ve Witness diskimiz hazır.

Diğer disklerimizide ekliyoruz Aynı şekilde.

Bir önceki adımda Targetları yaratmıştık şimdi targetları direk seçip ilerliyoruz.

Diğer disklerde bu şekilde yaratılır.

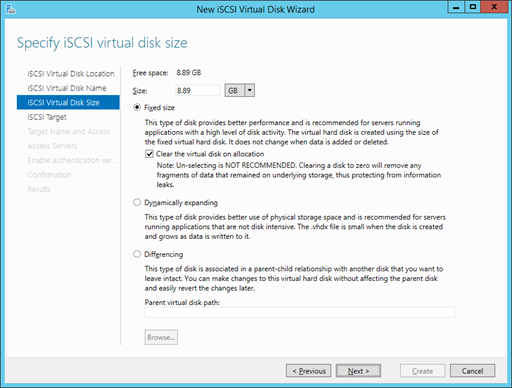

Buradaki disk yapılarına kısaca değinirsek

Fixed size: Diskten verilen alanı direk alıyor.Sabit boyutludur.Verdiğimiz alanın kullanılıp kullanılmamasının bir önemi yok.

Dynamically Expanding: Diskten verilen alanı direk almıyor.İhtiyacı kadar olanı alıyor ve ne kadar verdiysek maximum o kadar büyüyebiliyor.

Differencing: Bir tane parent diske bağlı fiziksel disklerdir.Dynamically expanding ile benzerdir.Performans için önerilmez.

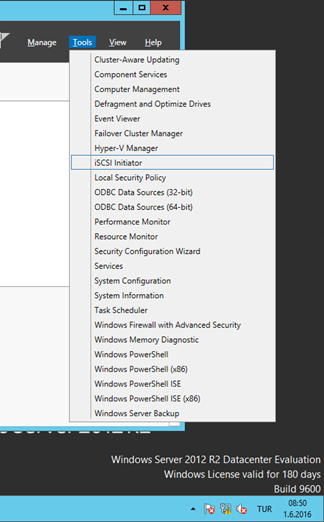

Diskler yaratıldıktan sonra node’lardan ISCSI initatior aracılığı ile diskleri bağlayacağız.

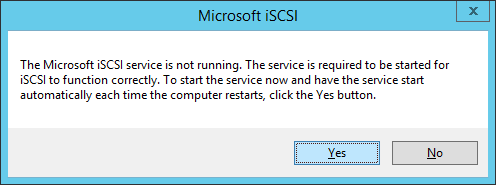

Servis başlamadığı için yes deyip servisi başlatıyoruz.

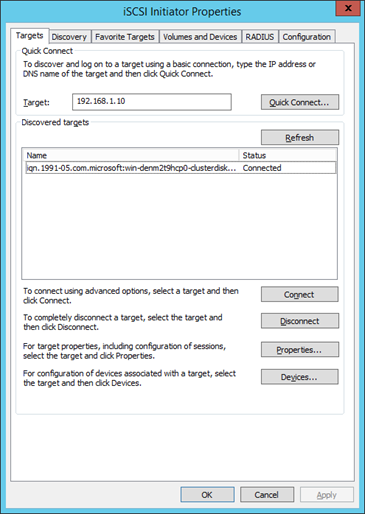

Storage ın Ip sini Target yazan yere yazıyoruz ve quick connect ile ilerliyoruz.Alt tarafta iqn.1991-05.com ile başlayan bir target görürüz.

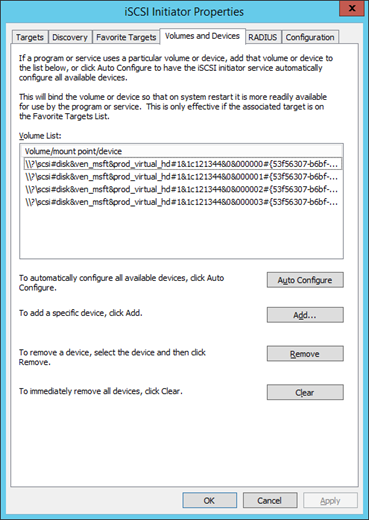

Daha sonra Volumes and Devices yazan yere gelip “Auto Configure” yapıyoruz.Kaç tane disk varsa hepsini görüyor olmalıyız.

Discovery den storage ın IP si ve portu bu işlemlerden sonra gelmiş olmalıdır.

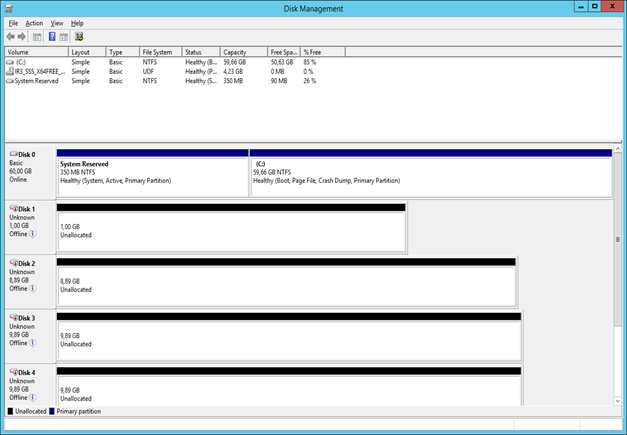

Node1 den işlemlere devam ediyorum. Run’ı çalıştırıp diskmgmt.msc komutuyla diskleri burada offline halde görürüz.

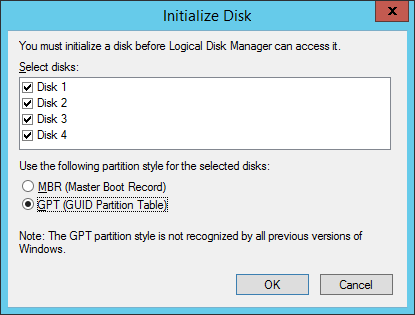

Node 1 den tüm diskleri online yapıyoruz.Daha sonra hepsini Initialize edeceğiz.

Bu işlemlerin hepsini NODE1 den yaptık.

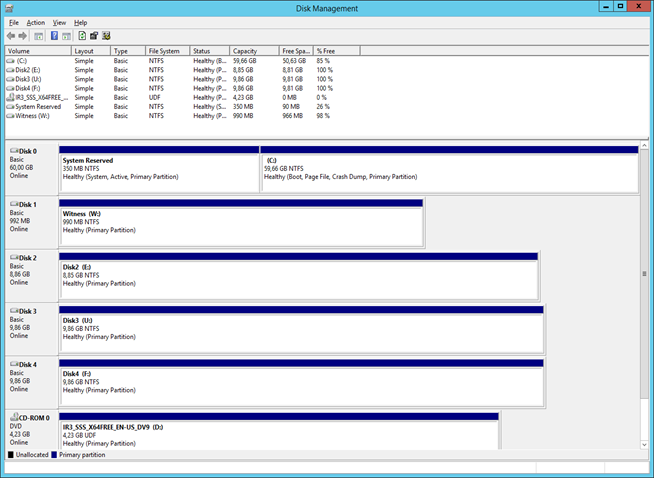

Disklerin hepsini NTFS olarak formatlayıp bağlıyoruz.

Bu aşamada NODE2 nin disk konfigürasyonuna gelip sadece online yaptığımız takdirde bağlandığını görürüz.Çünkü gerekli ayarları NODE1 den yapmıştık.

Arkadaşlar makalemin ilk bölümü burada sona erdi.

İkinci bölümde görüşmek dileğiyle

ellerine sağlık umut hocam …seni güzel yerlerde görmek istiyoruz artık..yırt kendini adamım 🙂

Çok başarılı bir makale olmuş. Ellerine sağlık Umutcum.

Muhteşem bir anlatım. Teşekkürler